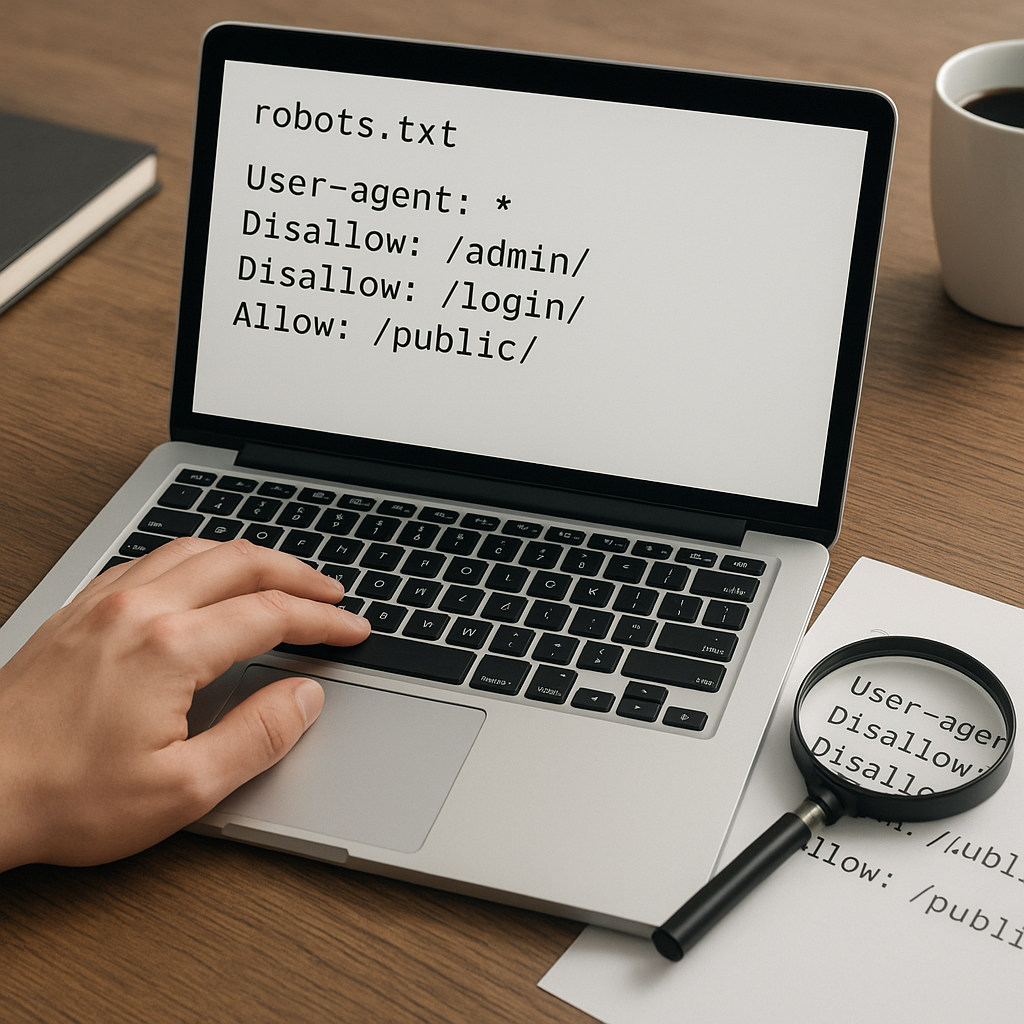

Plik robots.txt jest jednym z podstawowych narzędzi kontrolujących zachowanie robotów indeksujących na stronie. Przy audytowaniu witryny jego poprawność ma istotny wpływ na widoczność w wynikach wyszukiwania, wykorzystanie budżetu indeksowania i bezpieczeństwo niektórych zasobów. Poniższy artykuł opisuje, jak przeprowadzić kompleksową weryfikację pliku, jakie narzędzia wykorzystać oraz na co zwrócić szczególną uwagę podczas audytu.

Dlaczego plik robots.txt ma znaczenie w audycie

W kontekście audytów SEO i bezpieczeństwa plik robots.txt spełnia kilka funkcji. Po pierwsze, decyduje o dostępie robotów do określonych sekcji witryny — niewłaściwe reguły mogą zablokować strony istotne dla indeksacji. Po drugie, błędy w pliku wpływają na indeksacja i wykorzystanie budżetu indeksowania, szczególnie na dużych serwisach. Po trzecie, nieprawidłowo sformatowany lub dostępny plik może ujawnić struktury katalogów lub zasoby, które powinny pozostać prywatne.

Audyt pliku robots.txt nie ogranicza się do sprawdzenia jego treści. Trzeba także skontrolować sposób podawania pliku przez serwer (nagłówki HTTP, kod odpowiedzi), spójność z mapami witryny oraz wpływ na ruch botów (np. Googlebot). Kompleksowy audyt łączy analizę techniczną, testy manualne i narzędzia automatyczne.

Krok po kroku: jak sprawdzić poprawność pliku robots.txt

1. Lokalizacja i dostępność pliku

- Sprawdź, czy plik znajduje się pod adresem domena.pl/robots.txt. Jeśli serwer odpowiada kodem 404, brak pliku oznacza brak ograniczeń dla robotów (co też warto rozważyć).

- Zbadaj kod HTTP przy dostępie: 200 OK to pożądana odpowiedź. Kody 4xx i 5xx informują o problemach serwera i powinny zostać rozwiązane.

- Upewnij się, że plik jest dostępny zarówno pod http, jak i https, jeśli witryna obsługuje obie wersje. Preferowana jest wersja zabezpieczona.

2. Walidacja składni i formatowania

- Skontroluj, czy plik używa poprawnych dyrektyw: User-agent, Disallow, Allow, Sitemap, crawl-delay (opcjonalnie), oraz ewentualnych rozszerzeń zgodnych z REP (Robots Exclusion Protocol).

- Sprawdź kodowanie pliku — musi być czytelne dla serwera i robotów (zwykle UTF-8 bez BOM). Nieprawidłowe kodowanie może wprowadzać nieczytelne znaki.

- Zadbaj o brak ukrytych znaków, spacji na końcach linii, zbędnych komentarzy lub niestandardowych znaków, które mogą zaburzać interpretację.

3. Analiza reguł i ich priorytetów

- Sprawdź, czy reguły nie są sprzeczne. Przykładowo zapis blokujący katalog wyżej, a jednocześnie pozwalający na podstrony, może prowadzić do niejednoznaczności.

- Pamiętaj o zasadach dotyczących kolejności grup: grupy zaczynające się od konkretnego User-agent mają pierwszeństwo przed ogólnymi regułami dla gwiazdki.

- Testuj wzorce z użyciem wildcardów (*) i ukośników. Różne wyszukiwarki mogą różnie obsługiwać złożone wzorce, więc warto skupić się na kompatybilności z najważniejszymi botami.

4. Testy live i symulacje

- Użyj narzędzi do testowania, żeby symulować zachowanie konkretnych botów względem poszczególnych URL-i. Najbardziej pomocne są testery dostępne w Search Console oraz dedykowane skrypty.

- Przeanalizuj logi serwera: sprawdź, czy boty szanują reguły – czy zgłoszenia do zablokowanych zasobów kończą się kodami 403/200 zgodnie z oczekiwaniami.

- Przetestuj zmiany tymczasowo na środowisku testowym, zanim wprowadzisz je na produkcję.

Narzędzia i techniki audytowe

W audycie warto korzystać z zestawu narzędzi, które ułatwiają identyfikację problemów i symulację zachowań robotów.

- Google Search Console — Robots.txt Tester umożliwia sprawdzenie, czy konkretne URL-e są blokowane dla Googlebota.

- Narzędzia online do walidacji robots.txt — sprawdzają składnię i podstawowe konflikty reguł.

- curl lub wget do pobrania pliku i przeanalizowania nagłówków HTTP. Przykładowo: curl -I https://twojadomena.pl/robots.txt (sprawdź nagłówek Content-Type i kod odpowiedzi).

- Analiza logów serwera (access logs) — pozwala ocenić, jak roboty zachowują się w praktyce i które zasoby są najczęściej indeksowane lub skanowane.

- Skrypty i crawlery testowe — symulacja pracy bota pozwala zweryfikować, czy robot prawidłowo interpretuje reguły.

- Narzędzia do testowania wydajności i bezpieczeństwa — czasem plik robots.txt wykorzystywany jest przez skanery; monitoruj zmiany i dostęp do pliku.

Najczęstsze błędy i jak je naprawić

Poniżej lista typowych problemów wykrywanych podczas audytów oraz rekomendowane działania naprawcze.

- Brak pliku robots.txt — jeśli nie chcesz ograniczać botów, brak jest dopuszczalny, ale warto rozważyć kontrolę poprzez plik. Dodaj prosty plik z jasnymi regułami.

- Błędne blokowanie ważnych sekcji — często nieświadome dodanie reguły Disallow: / prowadzi do zablokowania całej strony. Usuń lub zmodyfikuj reguły, by zezwolić na indeksowanie istotnych stron.

- Konflikty reguł — usuń redundancję i uporządkuj plik według zasad specyficzności. Grupy dla konkretnych User-agent powinny być przemyślane.

- Nieaktualny plik po migracji — po zmianie struktury URL lub migracji serwisu zaktualizuj plik i przetestuj.

- Ujawnianie wrażliwych ścieżek — wpisy typu Disallow: /admin mogą sygnalizować istnienie panelu admina. Rozważ użycie kontroli dostępu zamiast polegania wyłącznie na robots.txt.

- Limitacja rozmiaru i kłopoty z kodowaniem — przy dużych plikach skróć lub uporządkuj wpisy. Google dopuszcza do 500 KB; trzymanie pliku poniżej tego rozmiaru minimalizuje ryzyko obcięcia przez roboty.

Praktyczna lista kontrolna do audytu robots.txt

Poniższa checklistę warto wykorzystać podczas audytów, żeby systematycznie weryfikować elementy krytyczne.

- Plik dostępny pod właściwym adresem i zwraca 200 OK.

- Poprawne kodowanie (UTF-8) i brak BOM.

- Brak ukrytych znaków i zbędnych komentarzy.

- Reguły są jasne i zgodne z wytycznymi ważnych wyszukiwarek.

- Sprawdzone konflikty między grupami User-agent.

- Weryfikacja najważniejszych URL-i poprzez testy manualne lub Search Console.

- Analiza logów serwera pod kątem zachowania botów.

- Aktualizacja dyrektywy Sitemap w pliku, jeśli mapa witryny jest dostępna.

- Kontrola wielkości pliku i zgodności z limitami (np. 500 KB dla Google).

- Dokumentacja zmian i plan wprowadzania poprawek, wraz z testami regresyjnymi.

Rola audytu w długoterminowym utrzymaniu witryny

Regularne audyty pliku robots.txt są elementem dobrych praktyk utrzymania witryny. W miarę rozwoju serwisu, zmiany w strukturze URL, migracje czy wdrażanie nowych sekcji, plik powinien być aktualizowany i ponownie przetestowany. Audyt pomaga zapobiegać przypadkowemu zablokowaniu ważnych zasobów oraz optymalizować wykorzystanie budżetu indeksowania.

Podczas audytu warto także uwzględnić szerszy kontekst: sprawdzenie pliku w powiązaniu z meta tagami robots na stronach, nagłówkami X-Robots-Tag oraz mapami witryny. Dzięki temu ocena jest pełna i pozwala na wyeliminowanie nie tylko błędów w samym pliku, ale również niespójności między różnymi mechanizmami kontrolującymi działanie robotów.

Rekomendacje końcowe dla audytora

Przy planowaniu audytu zachowaj metodyczne podejście: zacznij od podstaw (dostępność i nagłówki HTTP), przejdź do walidacji składni i zasad, a następnie wykonaj testy symulacyjne i analizę logów. Dokumentuj każde odkrycie i wprowadzane poprawki. W raportach audytowych wyjaśniaj wpływ wykrytych problemów na widoczność strony i zalecaj priorytety napraw. Pamiętaj też, by informować zespół techniczny o potencjalnych konsekwencjach zmian, szczególnie jeśli dotyczą one globalnych reguł blokujących.

Dobry audyt pliku robots.txt to nie tylko znalezienie błędów, ale także usprawnienie komunikacji z robotami tak, aby strona była lepiej indeksowana i bezpieczniejsza.

audyt-strony.pl

audyt-strony.pl  06.12.2025

06.12.2025

Skontaktuj się z nami

Skontaktuj się z nami